Videosynthesizer

Gabriele Piana

L’opera si fonda sul principio del videosintetizzatore generativo, un dispositivo che trasferisce nel dominio visivo la logica della sintesi sonora.

Come l’invenzione dell’oscillatore elettronico, sviluppato nei primi decenni del XX secolo da pionieri come Thaddeus Cahill e poi esplorato nella musica elettronica dagli anni ’50 da compositori quali Karlheinz Stockhausen, rese possibile la produzione di suoni non riconducibili a una fonte fisica, così questo strumento permette oggi di generare immagini dal nulla. L’oscillatore inaugurò un nuovo modo di concepire la composizione: non più catturare il reale, ma creare materia sonora pura, modulabile, viva, in continua trasformazione.

Nella storia della musica elettronica, questo segnò una frattura decisiva: il suono cessava di essere un oggetto registrato per diventare un fenomeno generato e manipolato in tempo reale, un atto di produzione immediata in cui esecuzione e creazione si fondono. Parallelo a queste innovazioni sonore, a partire dagli anni ’60 si svilupparono le prime sperimentazioni nella sintesi visiva e nella video arte. Artisti come Nam June Paik e i centri sperimentali statunitensi esplorarono le possibilità dei video-synthesizer, dispositivi capaci di generare immagini elettroniche astratte attraverso modulazioni di segnali video. Anche qui, come nella musica elettronica, l’immagine non era più un oggetto da riprendere o montare: diventava materia autonoma, modulabile, sensibile alle interazioni e all’istante creativo.

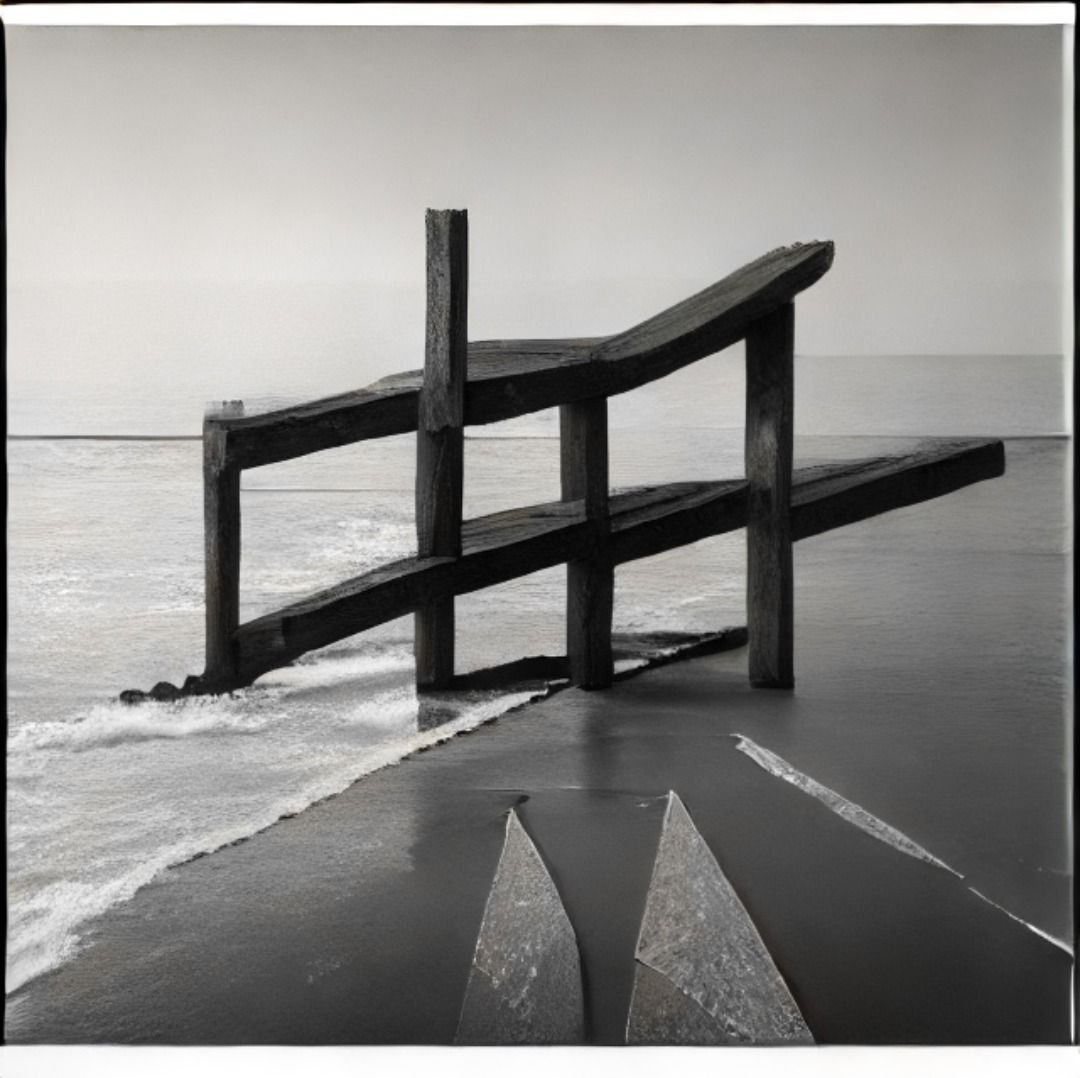

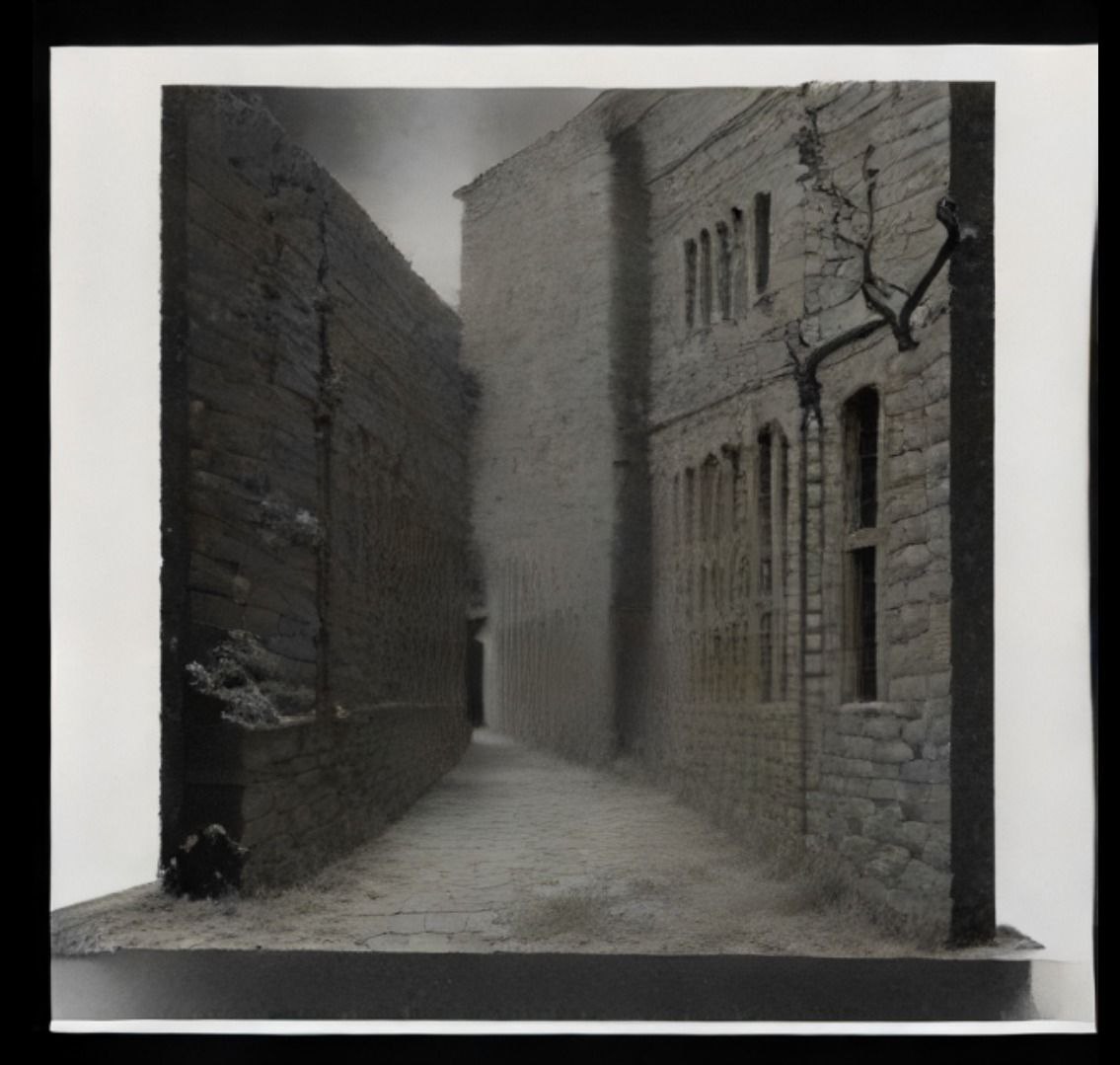

Con il videosintetizzatore, la ricerca di Gabriele Piana riattualizza questa rivoluzione visiva. Basato su un sistema di connessioni tra MaxMSP, LLM come Meta e StreamDiffusion di TouchDesigner, l’opera elabora flussi di input e output in cui rumore visivo e linguaggio verbale si intrecciano.

Il prompt testuale che orienta il processo generativo è autogenerato da un language model, introducendo un grado di autonomia e imprevedibilità, così che le immagini sembrano nascere e trasformarsi come forme viventi davanti agli occhi del fruitorə.

Un campo di noise struttura il movimento delle immagini, mentre l’interfaccia MIDI permette al pubblico di modulare in tempo reale ritmo, intensità e consistenza, sperimentando la sensazione fisica e percettiva di plasmare la luce stessa. Il prompt testuale che orienta il processo generativo è autogenerato da un language model, introducendo un grado di autonomia e imprevedibilità, così che le immagini sembrano nascere e trasformarsi come forme viventi davanti agli occhi del fruitorə. Un campo di noise struttura il movimento delle immagini, mentre l’interfaccia MIDI permette al pubblico di modulare in tempo reale ritmo, intensità e consistenza, sperimentando la sensazione fisica e percettiva di plasmare la luce stessa.

Il cuore dell’opera non sta nell’immagine prodotta, né sul dispositivo tecnologico, ma nel gesto di generare e plasmare forme e luce. Il pubblico è invitato a diventare parte del processo, a esplorare la possibilità di “suonare un’immagine”, trasformando la visione in gesto e percezione.

In questo spazio ludico e immersivo, il performer diventa prod-user: creatore e fruitore, corpo e mente che co-abitano il flusso generativo.

Come accadde con i primi sintetizzatori sonori, anche qui si apre un campo di libertà: un territorio dove la tecnologia non è cornice ma materia viva, dove il visibile e l’invisibile si intrecciano e l’immaginazione trova nuove strade, aperte alla sperimentazione collettiva e all’intuizione artistica.

testo a cura di Nicoletta Ceraolo

Un campo di noise struttura il movimento delle immagini, mentre l’interfaccia MIDI permette al pubblico di modulare in tempo reale ritmo, intensità e consistenza, sperimentando la sensazione fisica e percettiva di plasmare la luce stessa. Il prompt testuale che orienta il processo generativo è autogenerato da un language model, introducendo un grado di autonomia e imprevedibilità, così che le immagini sembrano nascere e trasformarsi come forme viventi davanti agli occhi del fruitorə. Un campo di noise struttura il movimento delle immagini, mentre l’interfaccia MIDI permette al pubblico di modulare in tempo reale ritmo, intensità e consistenza, sperimentando la sensazione fisica e percettiva di plasmare la luce stessa.

Il cuore dell’opera non sta nell’immagine prodotta, né sul dispositivo tecnologico, ma nel gesto di generare e plasmare forme e luce. Il pubblico è invitato a diventare parte del processo, a esplorare la possibilità di “suonare un’immagine”, trasformando la visione in gesto e percezione.

In questo spazio ludico e immersivo, il performer diventa prod-user: creatore e fruitore, corpo e mente che co-abitano il flusso generativo.

Come accadde con i primi sintetizzatori sonori, anche qui si apre un campo di libertà: un territorio dove la tecnologia non è cornice ma materia viva, dove il visibile e l’invisibile si intrecciano e l’immaginazione trova nuove strade, aperte alla sperimentazione collettiva e all’intuizione artistica.

testo a cura di Nicoletta Ceraolo

Bio

Gabriele Piana, alias Gapo, è diplomato all'Accademia Albertina di Belle Arti di Torino. È iscritto al corso “Nuove Tecnologie dell'Arte”, con specializzazione in Mostre Multimediali e Performance Digitali. È appassionato di modelli di generazione di immagini. Lo fa ridere poter trasformare le parole in immagini e ama stare sveglio tutta la notte davanti al PC.